大阪大学情報科学研究科の伊藤竜一と申します.2021年の夏期インターンシップに6週間参加し,期間後もアルバイトとして従事していました.プライバシを保護しながらパーソナルデータを含むデータの分析を可能にしたいというモチベーションから,データ生成と差分プライベート学習に関する研究を行いました.この記事では差分プライベート学習について紹介したいと思います.なお,より詳しい内容は第14回データ工学と情報マネジメントに関するフォーラム (DEIM2022) にて「低ランク近似を介した選択的パラメータ更新による差分プライベート学習」として発表予定です.

研究背景

個人に関するデータ,つまりパーソナルデータの利活用が進んでいます.パーソナルデータの利用はサービスに有用となることが多いですが,一方で個々人の特定やプライバシの開示を防ぐ必要があります.プライバシ保護技術は多数ありますが,今回は差分プライバシという指標に注目します.差分プライバシは,簡単に説明すると,「特定のデータが含まれているかどうかの識別が ϵ, δ というパラメータで指定した程度に困難である」ということを保証するプライバシ指標です.機械学習に差分プライバシを取り入れる手法としてはDifferentially-Private Stochastic Gradient Descent (DP-SGD) が広く知られています.SGDを拡張したもので,勾配を一定のノルムでクリッピングし,更にノイズを加算することで差分プライバシを満たした学習を実現します.差分プライバシを満たせる一方で,得られるモデルの有用性が低下するというトレードオフがあります.プライバシ保護をしても有用な出力が得られないモデルでは意味がないため,プライバシ強度は落とすことなく有用性を改善する必要があります.

既存研究と課題

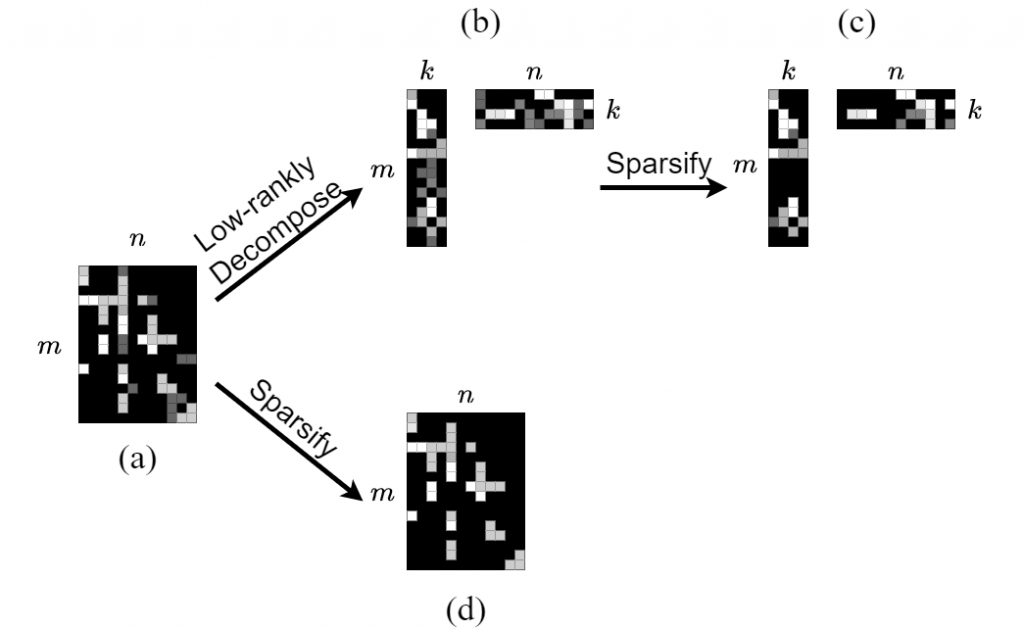

様々な先行研究により,ニューラルネットワークパラメータには出力への寄与が大きい重要なものとそうではないものが混在していることが知られています.この偏りはパラメータを行列として見たときに低ランク性やスパース性という形で現れます.この点に注目し,重要ではない重みの更新をスキップすることで,DP-SGDのクリッピングやノイズの影響を減らし,有用性を改善するという既存研究があります.既存研究では,図1(a)から図1(b)のようにランク k に行列分解することでパラメータ数を mn から k(m+n) に削減するか,図1(d)のようにスパース性 p を仮定することでパラメータ数を mn100−p 100 に削減しています.

更新するパラメータを減らすとクリッピングやノイズの影響軽減によって有用性が向上しますが,一方で,更新対象外となったパラメータの勾配情報損失による有用性低下が発生しトレードオフとなります.そのため,低ランク性やスパース性といった性質をできる限り利用して重要なパラメータを選択する必要があります.しかしながら,ニューラルネットワークにおけるスパース性は低ランク化していないパラメータに表れるものであり,単純には低ランク化したパラメータに仮定できないため,既存研究ではいずれかの性質しか利用されていません.

提案手法

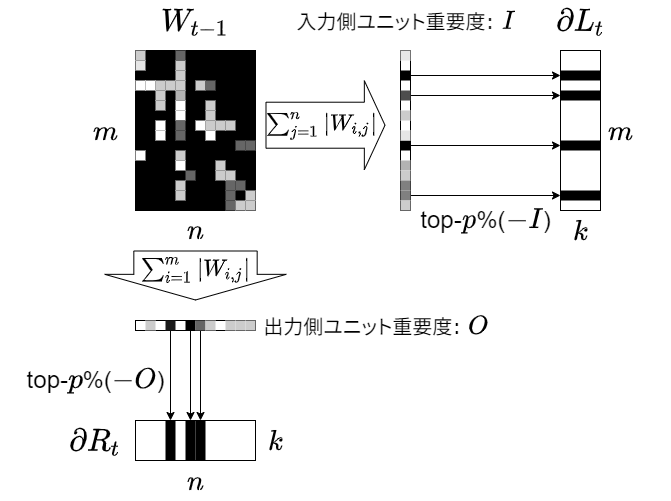

本研究では,低ランク性とスパース性を併用して更新対象パラメータを削減することで有用性を改善する学習手法を提案します.図2に概要を示します.これまで排他的だった低ランク性とスパース性の併用を,ユニットレベルの重要度を定義することで実現します.入力側ユニットと出力側ユニットのぞれぞれで接続されているシナプスの重要度の総和を計算し,それを各ユニットの重要度として定義します.任意の低ランク化手法で分解された勾配行列 (∂L,∂R) を取得した後,各ユニットがランク分解された行列にも対応があることを利用してスパース化を行います.具体的には,入力側ユニットが ∂L の行と,出力側ユニットが ∂R の列と対応するため,それぞれで重要度の低い p% のパラメータを更新対象から除外します.これにより,低ランク性とスパース性を併用しながら更新対象パラメータを k(m+n)100−p 100 に削減できます.

評価実験

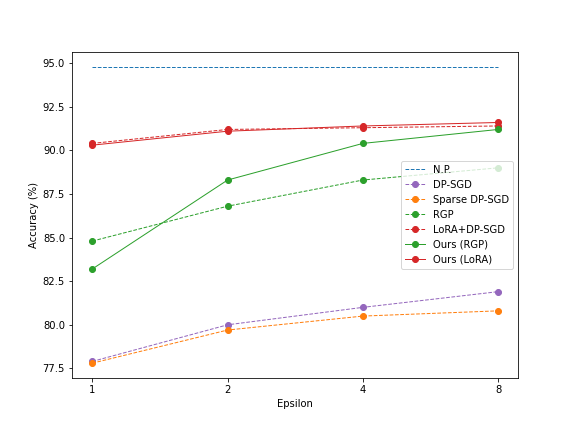

自然言語処理ベンチマークGLUEを用いて,RoBERTaモデルをファインチューニングする形で評価実験を行いました.図3がプライバシ強度を表すパラメータ ϵ を変えたときの各手法の正答率(有用性)です.低ランク性を取り入れる手法としてRGPを用いた場合,提案手法によるスパース化との併用 (Ours (RGP)) を行うことで多くのケースで有用性の改善が確認できました.一方で,別の低ランク性を取り入れる手法としてLoRAを用いた場合は提案手法 (Ours (LoRA)) を用いても大きな変化は見られませんでした.

まとめ

ニューラルネットワークパラメータの低ランク性とスパース性に基づき更新対象パラメータを適切に選択することで,差分プライバシを満たし有用性の高いモデルを獲得する学習手法を提案しました.評価実験を行い,一部の低ランク性を取り入れる手法と組み合わせることでモデルの有用性が改善することを確認しました.今後差分プライベート学習のための新たな低ランク化手法が提案された際には,更なる性能向上への貢献が期待できます.

プライバシ分野は自分にとって未知の世界でしたが,メンターの方々にサポートしていただきながらここまでまとめることができました.また,フルリモートだったためコミュニケーション面がやや不安でしたが,毎日議論する時間を設けていただき不自由なく研究を進めることができました.様々な議論ができ,新たな視点も増えた,とても有意義なインターンシップでした.